Trong thế giới trí tuệ nhân tạo, khả năng “học từ kinh nghiệm” không còn là điều viễn tưởng. Reinforcement Learning (học tăng cường) chính là một bước tiến vượt bậc giúp máy móc không chỉ ghi nhớ dữ liệu mà còn tự đưa ra quyết định thông minh dựa trên phần thưởng – tương tự cách con người học hỏi qua thử và sai. Trong bài viết này, Base.vn sẽ cùng bạn khám phá khái niệm Reinforcement Learning là gì, cách nó vận hành và lý do tại sao cơ chế học này đang trở thành nền tảng của các hệ thống AI hiện đại như xe tự lái, robot hay cá nhân hóa trải nghiệm người dùng.

1. Giới thiệu về Reinforcement Learning

1.1 Reinforcement Learning là gì?

Reinforcement Learning (Học tăng cường) là một phương pháp trong lĩnh vực Machine Learning (học máy), cho phép phần mềm học cách ra quyết định thông qua quá trình tương tác với môi trường nhằm tối đa hóa kết quả đạt được. Cơ chế học này mô phỏng quá trình con người học từ kinh nghiệm, thông qua việc thử, sai và điều chỉnh để dần dần hoàn thiện hành vi hướng tới mục tiêu. Trong quá trình đó, hệ thống sẽ được “khuyến khích” thực hiện những hành động mang lại lợi ích cao và “hạn chế” các hành động kém hiệu quả hoặc gây ảnh hưởng tiêu cực đến mục tiêu cuối cùng.

Trong những năm gần đây, Machine Learning (học máy) trở thành một trong những công nghệ được quan tâm và ứng dụng rộng rãi nhất. Từ các nền tảng mạng xã hội, thương mại điện tử đến lĩnh vực marketing số, học máy góp phần tạo nên nhiều giá trị thiết thực, giúp cải thiện trải nghiệm người dùng và tối ưu hiệu quả hoạt động.

Các thuật toán trong học máy thường được chia thành ba nhóm chính:

- Học có giám sát (supervised learning): mô hình học từ một bộ dữ liệu đã được gắn nhãn sẵn, nhằm tìm ra mối quan hệ giữa đầu vào và đầu ra.

- Học không giám sát (unsupervised learning): mô hình chỉ được cung cấp dữ liệu thô, chưa qua gắn nhãn, và có nhiệm vụ tự khám phá cấu trúc tiềm ẩn hoặc các mẫu trong dữ liệu đó.

- Học tăng cường (reinforcement learning): mô hình học thông qua quá trình tương tác với môi trường.

Khác với học có giám sát, vốn dựa trên dữ liệu đã được gắn nhãn cụ thể, học tăng cường không có sẵn thông tin chính xác về hành động đúng hay sai. Thay vào đó, tác tử cần thử nghiệm, khám phá và điều chỉnh hành vi dựa trên kết quả nhận được từ môi trường.

1.2 Các thuật ngữ liên quan

Trong Reinforcement Learning (học tăng cường), có rất nhiều thuật ngữ chuyên ngành được sử dụng để mô tả các thành phần và quá trình trong hệ thống. Dưới đây là một số khái niệm cơ bản thường gặp, cùng với phần giải thích ngắn gọn để giúp bạn hiểu rõ hơn:

- Agent (Tác tử): Agent là thực thể đóng vai trò trung tâm trong hệ thống học tăng cường. Nó có khả năng “cảm nhận” môi trường xung quanh thông qua các cảm biến và đưa ra hành động thông qua bộ điều khiển. Hiểu đơn giản, đây là nhân vật chính thực hiện hành động và học hỏi từ môi trường.

- Environment (Môi trường): Môi trường là không gian mà agent tương tác, tồn tại và phản hồi lại các hành động từ agent. Nó đóng vai trò cung cấp dữ liệu đầu vào cho agent và thay đổi theo hành động của agent.

- Action (Hành động): Hành động là cách mà agent tương tác với môi trường tại mỗi thời điểm. Dựa trên trạng thái hiện tại của môi trường (state), agent sẽ lựa chọn một hành động phù hợp để thực hiện.

- Observation (Quan sát): Sau khi agent thực hiện một hành động, môi trường phản hồi lại bằng cách thay đổi trạng thái. Agent tiếp nhận phản hồi này dưới dạng quan sát, chính là thông tin mô tả tình hình hiện tại của môi trường sau tác động của hành động vừa thực hiện.

- State (Trạng thái): Trạng thái thể hiện tình huống hiện tại của môi trường mà agent đang “nhìn thấy” hoặc cảm nhận được. Đây là cơ sở để agent quyết định hành động tiếp theo.

- Policy (Chính sách): Chính sách là chiến lược mà agent sử dụng để lựa chọn hành động tại mỗi trạng thái. Nó đóng vai trò cốt lõi trong việc xác định hành vi của agent. Chính sách có thể là một hàm toán học, một bảng tra cứu, hoặc một mô hình phức tạp tùy vào mức độ phức tạp của bài toán.

- Reward (Phần thưởng): Sau mỗi hành động, agent sẽ nhận được một tín hiệu phản hồi từ môi trường gọi là phần thưởng. Mục tiêu chính của agent là tối đa hóa tổng phần thưởng nhận được trong quá trình tương tác lâu dài với môi trường. Dựa vào phần thưởng này, agent sẽ điều chỉnh chính sách để đưa ra những hành động hiệu quả hơn trong tương lai.

- Khai thác (Exploit): Là việc agent chọn hành động dựa trên kinh nghiệm trước đó để tối đa hóa phần thưởng, sử dụng những gì đã biết để đưa ra quyết định tốt nhất tại thời điểm hiện tại.

- Khám phá (Explore): Là quá trình agent thử các hành động mới (thường là ngẫu nhiên) để thu thập thêm thông tin về môi trường, từ đó tìm ra các hành động tiềm năng có thể mang lại phần thưởng cao hơn trong tương lai.

1.3 Ví dụ về Reinforcement Learning

Ví dụ: Một đứa trẻ học cách đi xe đạp

Một đứa trẻ lần đầu tiên tập đi xe đạp sẽ gặp rất nhiều khó khăn: có thể bị ngã, mất thăng bằng hoặc đạp sai cách. Ban đầu, trẻ sẽ thử nhiều cách khác nhau, giữ tay lái chặt hơn, đạp nhanh hơn, nghiêng người sang trái hoặc phải để tìm ra cách giữ được thăng bằng.

Qua mỗi lần thử và lỗi (ngã, suýt ngã, đi được vài mét rồi dừng,…), đứa trẻ dần học được phản ứng phù hợp: khi cảm thấy mất thăng bằng sang phải thì nghiêng người sang trái, hoặc khi xe chậm lại thì phải đạp nhanh hơn. Sau nhiều lần tập luyện, trẻ sẽ biết cách giữ thăng bằng tốt hơn, rẽ đúng lúc, dừng xe an toàn, và cuối cùng là đạp xe một cách thành thạo mà không cần nghĩ quá nhiều.

Giải thích dưới góc độ Reinforcement Learning:

- Agent (tác tử): đứa trẻ

- Environment (môi trường): chiếc xe, mặt đường, thời tiết, địa hình xung quanh

- Action (hành động): đạp, nghiêng người, bẻ lái, phanh

- State (trạng thái): vị trí hiện tại, độ nghiêng, tốc độ xe

- Reward (phần thưởng): giữ được thăng bằng, đi được xa mà không ngã

- Policy (chính sách): chiến lược học được để phản ứng phù hợp trong từng tình huống

Tại sao đây là Reinforcement Learning?- Vì đứa trẻ không biết trước cách đạp xe đúng, mà phải học dần từ trải nghiệm thực tế. Không có ai cung cấp cho trẻ mọi quy tắc chi tiết, đứa trẻ phải tự học thông qua việc tương tác với môi trường, điều chỉnh hành vi để tối ưu hóa phần thưởng (giữ thăng bằng và đi được xa hơn), đúng như bản chất của Reinforcement Learning.

Đọc thêm: Transfer Learning là gì? Cách máy học tăng tốc nhờ kiến thức cũ

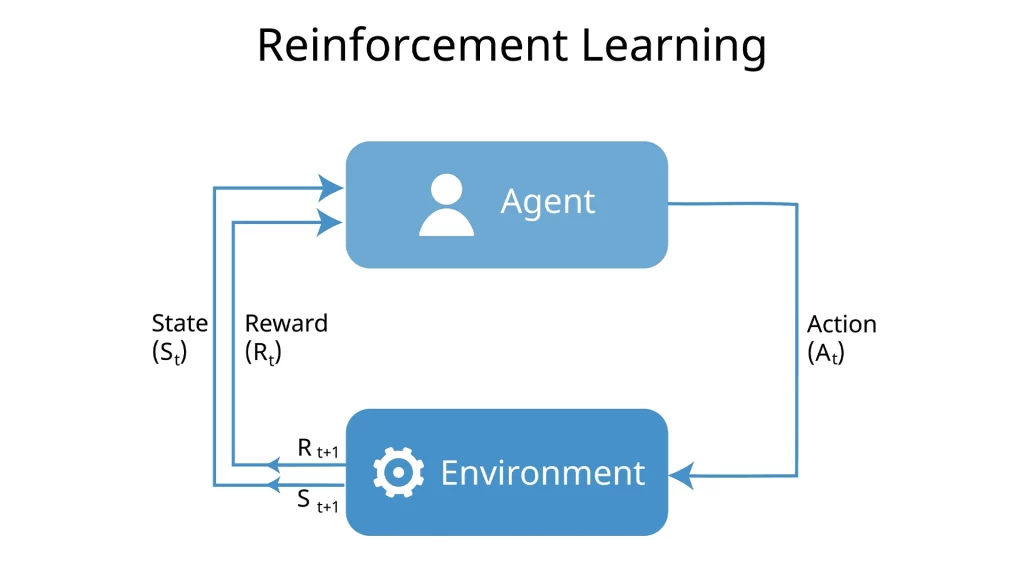

2. Nguyên lý hoạt động của Reinforcement Learning

Về mặt nguyên lý, Reinforcement Learning mô phỏng quá trình học tập thông qua trải nghiệm giống như cách con người và các loài động vật học hỏi từ thử nghiệm và rút kinh nghiệm. Chẳng hạn, một đứa trẻ dần nhận ra rằng việc cư xử tốt như giúp đỡ người khác hay làm việc nhà sẽ nhận được sự khen ngợi, trong khi những hành vi không phù hợp như hét to hoặc ném đồ chơi thường khiến người lớn không hài lòng. Thông qua đó, trẻ học được cách hành động để đạt được những kết quả tích cực. Tương tự, các thuật toán học tăng cường cũng học bằng cách thử nhiều hành động khác nhau trong một môi trường để tìm ra hướng đi hiệu quả nhất, giúp tối đa hóa phần thưởng đạt được.

Về cơ chế vận hành, Reinforcement Learning được xây dựng dựa trên khái niệm Markov Decision Process (MDP – Quá trình quyết định Markov). Trong mô hình này, tác tử (agent) tương tác với môi trường theo từng bước thời gian. Cụ thể:

- Dựa trên trạng thái hiện tại của môi trường, tác tử lựa chọn một hành động phù hợp.

- Môi trường sau đó phản hồi lại bằng cách chuyển sang trạng thái mới và cung cấp một phần thưởng tương ứng.

- Dựa trên phản hồi nhận được, tác tử điều chỉnh hành vi (chính sách hành động) nhằm tối ưu hóa phần thưởng trong tương lai.

Trong quá trình học tập này, tác tử phải liên tục cân nhắc giữa hai chiến lược quan trọng:

- Khám phá (Exploration): Thử những hành động mới để hiểu rõ hơn về môi trường.

- Khai thác (Exploitation): Áp dụng những hành động đã biết có khả năng mang lại phần thưởng cao.

Việc duy trì sự cân bằng hợp lý giữa khám phá và khai thác là yếu tố then chốt để tác tử dần hoàn thiện chính sách hành động tối ưu, từ đó đạt được kết quả tốt nhất trong môi trường mà nó đang hoạt động.

3. Lợi ích và hạn chế của phương pháp học tăng cường

3.1 Lợi ích

Reinforcement Learning có khả năng giải quyết các bài toán phức tạp mà nhiều phương pháp học máy truyền thống không thể xử lý hiệu quả. Đây được đánh giá là một trong những bước tiến nổi bật của lĩnh vực trí tuệ nhân tạo bởi khả năng tự động khám phá giải pháp tối ưu mà không cần được lập trình chi tiết từng bước. Một số lợi ích nổi bật của phương pháp này bao gồm:

- Hướng đến mục tiêu tổng thể: Không giống như các thuật toán truyền thống thường chia nhỏ vấn đề thành các bước riêng lẻ để xử lý, học tăng cường tập trung trực tiếp vào việc tối ưu hóa phần thưởng trong dài hạn. Điều này giúp hệ thống hiểu rõ hơn mục tiêu cuối cùng và có khả năng cân nhắc giữa lợi ích trước mắt và lợi ích về sau.

- Chủ động thu thập dữ liệu: Thay vì phụ thuộc vào tập dữ liệu huấn luyện cố định, Reinforcement Learning học bằng cách tương tác với môi trường và từ đó tự tạo ra dữ liệu. Điều này giúp giảm nhu cầu chuẩn bị dữ liệu ban đầu và mang lại sự linh hoạt cao trong quá trình học.

- Khả năng thích nghi cao: Nhờ học hỏi từ kinh nghiệm liên tục, Reinforcement Learning có thể điều chỉnh hành vi khi môi trường thay đổi, điều mà các thuật toán truyền thống khó thực hiện nếu không huấn luyện lại. Nhờ đó, học tăng cường phù hợp với các môi trường động và nhiều yếu tố không chắc chắn.

3.2 Hạn chế

Mặc dù Reinforcement Learning có nhiều ưu điểm và lợi ích, việc triển khai nó trong thực tế vẫn còn gặp phải nhiều hạn chế. Dưới đây là một số thách thức chính khiến học tăng cường chưa thể phổ biến rộng rãi:

- Đòi hỏi khối lượng dữ liệu lớn: Học tăng cường thu thập dữ liệu thông qua quá trình tương tác với môi trường, tuy nhiên tốc độ thu thập lại bị hạn chế bởi tính chất động lực học của môi trường đó. Trong các hệ thống có độ trễ cao hoặc không gian trạng thái quá phức tạp, tác tử cần phải thực hiện rất nhiều thử nghiệm mới có thể tìm ra chiến lược hiệu quả, dẫn đến quá trình học trở nên kéo dài và tiêu tốn nhiều tài nguyên.

- Khó khăn với phần thưởng xuất hiện muộn: Reinforcement Learning phụ thuộc vào phần thưởng để điều chỉnh hành vi, nhưng trong nhiều tình huống thực tế, phần thưởng không xuất hiện ngay sau từng hành động mà chỉ được nhận sau một chuỗi hành động dài. Điều này khiến việc xác định hành động nào thực sự đóng góp vào kết quả thành công trở nên không rõ ràng, từ đó gây khó khăn trong việc tối ưu chính sách.

- Hạn chế trong khả năng diễn giải: Ngay cả khi tác tử đã học được một chính sách tốt, việc lý giải vì sao nó đưa ra các quyết định cụ thể vẫn còn là một thách thức. Điều này làm giảm mức độ tin tưởng của con người vào hệ thống, đặc biệt trong những lĩnh vực nhạy cảm như y tế, tài chính, hay hàng không. Nếu có thể hiểu được logic phía sau hành động của tác tử, chúng ta không chỉ có thể cải thiện hệ thống mà còn phát hiện và xử lý các điểm yếu tiềm ẩn trong mô hình.

4. Phân loại Reinforcement Learning

Reinforcement Learning (RL) có thể được phân loại thành hai nhóm chính: Học tăng cường có mô hình (Model-based RL) và Học tăng cường không có mô hình (Model-free RL). Sự khác biệt giữa hai phương pháp này chủ yếu nằm ở cách thức tác tử học hỏi và đưa ra quyết định.

4.1 Học tăng cường dựa trên mô hình (Model-based RL)

Trong phương pháp này, tác tử xây dựng một mô hình nội bộ của môi trường, từ đó có thể dự đoán phần thưởng cho từng hành động trước khi thực hiện. Mục tiêu của tác tử là tối đa hóa phần thưởng thông qua các quyết định dựa trên mô hình này. Model-based RL rất phù hợp với các môi trường tĩnh, nơi các kết quả của hành động có thể được xác định rõ ràng và không thay đổi.

Ưu điểm:

- Không cần một lượng lớn dữ liệu để huấn luyện.

- Tiết kiệm thời gian nhờ khả năng dự đoán thay vì chỉ dựa vào thử nghiệm thực tế.

- Cung cấp một môi trường an toàn để kiểm tra và khám phá chiến lược.

Nhược điểm:

- Hiệu quả phụ thuộc vào độ chính xác của mô hình; nếu mô hình không chính xác, hiệu suất có thể bị giảm.

- Độ phức tạp cao, đòi hỏi nhiều tài nguyên tính toán.

- Không thích hợp cho các môi trường thay đổi liên tục hoặc không ổn định.

4.2 Học Tăng Cường Không Mô Hình (Model-free RL)

Phương pháp này không yêu cầu tác tử xây dựng mô hình nội bộ của môi trường. Thay vào đó, tác tử học hỏi từ các thử nghiệm và sai sót bằng cách thực hiện các hành động và quan sát kết quả để xây dựng chiến lược tối ưu (chính sách) nhằm tối đa hóa phần thưởng. Model-free RL thường được áp dụng cho các môi trường phức tạp hoặc không xác định, nơi các yếu tố thay đổi liên tục.

Ưu điểm:

- Không phụ thuộc vào độ chính xác của mô hình môi trường.

- Ít yêu cầu tính toán phức tạp hơn so với Model-based RL.

- Thích hợp cho các tình huống thực tế, nơi môi trường có thể thay đổi hoặc khó dự đoán.

Nhược điểm:

- Cần thực hiện nhiều thử nghiệm hơn, dẫn đến mất nhiều thời gian hơn.

- Có thể gặp rủi ro khi áp dụng vào thực tế, do phải thực hiện các hành động mà không có dự đoán trước về kết quả.

5. Các thuật toán quan trọng trong Reinforcement Learning

Thuật toán Reinforcement Learning xác định cách mà tác tử (agent) học hỏi và thực hiện các hành động phù hợp thông qua phần thưởng nhận được từ môi trường. Mỗi thuật toán được thiết kế để xử lý các bài toán và môi trường khác nhau, và chúng có thể được phân chia thành hai nhóm chính: thuật toán dựa trên giá trị (Value-Based) và thuật toán dựa trên chính sách (Policy-Based).

5.1 Thuật toán dựa trên giá trị (Value-Based Algorithms)

Các thuật toán trong nhóm này tập trung vào việc ước lượng giá trị của các trạng thái trong môi trường. Giá trị này thể hiện phần thưởng kỳ vọng mà tác tử có thể nhận được khi bắt đầu từ một trạng thái nhất định và thực hiện một loạt hành động.

- Q-Learning: Q-Learning là một thuật toán Model-Free, Off-Policy, có nghĩa là nó không yêu cầu mô hình môi trường trước và có thể học từ các hành động không nhất thiết phải tuân theo chính sách hiện tại. Thuật toán này sử dụng bảng Q (Q-table), trong đó mỗi ô lưu trữ giá trị Q cho mỗi cặp trạng thái – hành động. Trong quá trình huấn luyện, giá trị Q sẽ được cập nhật dựa trên phản hồi từ môi trường. Khi thực hiện, tác tử tra cứu bảng Q để chọn hành động có giá trị cao nhất, nhằm tối ưu hóa phần thưởng cho các hành động tiếp theo.

- Deep Q-Networks (DQN): DQN là một phiên bản mở rộng của Q-Learning, trong đó bảng Q được thay thế bằng mạng nơ-ron nhân tạo để ước lượng giá trị Q. Phương pháp này rất hữu ích trong các môi trường có không gian trạng thái rộng lớn, nơi mà việc lưu trữ và cập nhật bảng Q trở nên khó khăn. Bằng cách sử dụng mạng nơ-ron, DQN giúp tác tử có khả năng tổng quát hóa, đưa ra các quyết định chính xác ngay cả trong những trạng thái chưa từng gặp.

- SARSA (State-Action-Reward-State-Action): SARSA là một thuật toán On-Policy, có nghĩa là tác tử học hỏi theo chính sách hiện tại thay vì khám phá toàn bộ môi trường như Q-Learning. Thuật toán này cập nhật giá trị Q dựa trên hành động thực tế mà tác tử thực hiện theo chính sách đang sử dụng. Do đó, SARSA thích hợp với các bài toán yêu cầu hành vi ổn định và an toàn hơn, đặc biệt trong môi trường có rủi ro cao.

5.2 Thuật toán dựa trên chính sách (Policy-Based Algorithms)

Khác với các thuật toán dựa trên giá trị, nhóm thuật toán này trực tiếp tối ưu hóa chính sách, tức là các quy tắc giúp tác tử chọn hành động phù hợp trong từng trạng thái. Các thuật toán này cập nhật chính sách trực tiếp nhằm tối đa hóa phần thưởng nhận được. Một số thuật toán dựa trên policy gradient bao gồm: REINFORCE, Proximal Policy Optimization (PPO), Trust Region Policy Optimization (TRPO), Actor-Critic, Advantage Actor-Critic (A2C), Deep Deterministic Policy Gradient (DDPG), và Twin-Delayed DDPG (TD3).

Đọc thêm: Deep Learning là gì? Tìm hiểu cách máy học sâu hoạt động

6. Ứng dụng của Reinforcement Learning

Hiện nay, Reinforcement Learning đang dần thay đổi cách con người tiếp cận và giải quyết các bài toán phức tạp trong thực tiễn. Với khả năng học hỏi từ kinh nghiệm và đưa ra các quyết định tối ưu trong môi trường có nhiều biến động, RL đang được ứng dụng ngày càng rộng rãi trong các lĩnh vực đòi hỏi độ chính xác cao như robotics, y học, tài chính, năng

6.1 Robotics và phương tiện tự hành

Trong lĩnh vực tự động hóa, học tăng cường đóng vai trò quan trọng trong việc giúp các hệ thống robot và phương tiện tự hành học cách tương tác hiệu quả với môi trường xung quanh. Thay vì lập trình cứng nhắc, chúng học từ thử, sai để cải thiện hiệu suất hành động.

- Ứng dụng trong robot công nghiệp: Reinforcement Learning giúp robot học cách thao tác với vật thể, di chuyển chính xác và thích nghi với nhiều môi trường khác nhau. Ví dụ, cánh tay robot của DeepMind có thể tự học cách sắp xếp vật phẩm thông qua các thử nghiệm lặp lại.

- Xe tự lái: Xe tự hành được huấn luyện bằng Reinforcement Learning để nhận diện tình huống, điều hướng linh hoạt và tối ưu hóa đường đi, giúp tăng độ an toàn và giảm tiêu thụ nhiên liệu.

6.2 Y học và phát triển dược phẩm

Trong ngành y tế và dược phẩm, Reinforcement Learning góp phần tạo ra các giải pháp cá nhân hóa và đẩy nhanh quá trình nghiên cứu bằng cách mô phỏng và đưa ra quyết định dựa trên dữ liệu y khoa và phản ứng sinh học.

- Tối ưu phác đồ điều trị: Các hệ thống sử dụng học tăng cường có thể đề xuất kế hoạch điều trị phù hợp với từng bệnh nhân, nhất là trong điều trị ung thư và các bệnh mãn tính phức tạp.

- Thiết kế thuốc: Reinforcement Learning được dùng để khám phá các phân tử mới có tiềm năng điều trị, bằng cách mô phỏng các phản ứng hóa học và tối ưu hóa khả năng liên kết của thuốc với mục tiêu sinh học.

6.3 Tài chính và đầu tư

Reinforcement Learning đang trở thành công cụ đắc lực trong ngành tài chính, nơi mà tốc độ phản ứng và độ chính xác trong quyết định đầu tư có thể tạo ra sự khác biệt lớn.

- Giao dịch thông minh: Các thuật toán học tăng cường có thể điều chỉnh chiến lược mua bán trong thời gian thực để tận dụng cơ hội sinh lời. Ví dụ: LOXM của J.P. Morgan sử dụng Reinforcement Learning để tối ưu hóa các giao dịch tài chính với độ trễ thấp.

- Quản lý danh mục đầu tư: Reinforcement Learning giúp cân bằng giữa lợi nhuận và rủi ro bằng cách học từ các biến động thị trường và cập nhật chiến lược đầu tư liên tục theo thời gian.

6.4 Sản xuất và bảo trì

Trong sản xuất, học tăng cường mang lại hiệu quả vượt trội nhờ khả năng thích nghi và tự động điều chỉnh theo điều kiện vận hành. Đây là bước tiến lớn trong việc nâng cao năng suất và tiết kiệm chi phí.

- Tối ưu dây chuyền sản xuất: Các hệ thống học tăng cường có thể điều chỉnh tham số sản xuất để tối đa hóa hiệu quả và hạn chế lãng phí nguyên vật liệu.

- Bảo trì dự đoán: Thay vì chờ máy móc hỏng hóc, Reinforcement Learning giúp dự đoán thời điểm cần bảo trì bằng cách phân tích dữ liệu vận hành, từ đó ngăn ngừa sự cố bất ngờ và giảm chi phí sửa chữa.

6.5 Năng lượng và hệ thống điện thông minh

Trong bối cảnh nhu cầu sử dụng năng lượng ngày càng tăng, Reinforcement Learning mang đến giải pháp thông minh cho việc quản lý, phân phối và tiết kiệm năng lượng một cách hiệu quả hơn.

- Quản lý lưới điện: Học tăng cường giúp cân bằng cung – cầu năng lượng, đặc biệt khi tích hợp các nguồn năng lượng tái tạo có tính biến động cao. DeepMind từng áp dụng Reinforcement Learning để giúp trung tâm dữ liệu Google tiết kiệm tới 40% năng lượng tiêu thụ.

- Tối ưu hóa việc sạc xe điện: Reinforcement Learning hỗ trợ xác định thời điểm sạc pin lý tưởng nhằm giảm tải cho lưới điện và tối ưu chi phí điện năng.

6.6 Trò chơi và mô phỏng thực tế ảo

Reinforcement Learning được xem là một trong những công nghệ cốt lõi đứng sau sự phát triển của AI trong game và mô phỏng ảo, nơi hành vi học hỏi từ trải nghiệm đóng vai trò then chốt.

- AI trong game: Reinforcement Learning được dùng để huấn luyện AI chơi game chiến thuật như cờ vây hoặc game đối kháng. AlphaGo – hệ thống AI của DeepMind là ví dụ nổi bật khi đánh bại nhà vô địch thế giới trong môn cờ vây.

- Mô phỏng và huấn luyện: Học tăng cường còn được sử dụng để tạo ra các môi trường mô phỏng thực tế, phục vụ cho nghiên cứu hành vi, huấn luyện kỹ năng hoặc kiểm thử sản phẩm công nghệ.

6.7 Marketing

Reinforcement Learning có thể giúp các doanh nghiệp xây dựng chiến lược marketing thông minh hơn, tối ưu hóa trải nghiệm khách hàng và tăng trưởng doanh thu hiệu quả.

- Tối ưu hóa chiến lược marketing: Học tăng cường có thể được sử dụng để tối ưu hóa các chiến dịch marketing trực tuyến, bao gồm việc lựa chọn quảng cáo, đối tượng mục tiêu và các kênh phân phối. Qua việc học từ hành vi và phản hồi của khách hàng, mô hình có thể đưa ra các quyết định chiến lược giúp nâng cao hiệu quả chiến dịch.

- Cá nhân hóa trải nghiệm khách hàng: Reinforcement Learning hỗ trợ xây dựng các mô hình cá nhân hóa, giúp doanh nghiệp tối ưu hóa nội dung và khuyến mại cho từng khách hàng dựa trên hành vi và sở thích riêng biệt của họ. Việc này giúp tăng tỷ lệ chuyển đổi và sự hài lòng của khách hàng.

- Chạy thử và tối ưu hóa các chiến dịch quảng cáo: Học tăng cường có thể giúp tối ưu hóa chiến lược quảng cáo trên các nền tảng như Google Ads hay Facebook Ads. Hệ thống học hỏi từ các phản hồi trong quá trình chiến dịch diễn ra và điều chỉnh lại ngân sách, đối tượng mục tiêu hoặc thông điệp quảng cáo để đạt hiệu quả tối đa.

- Phân tích dữ liệu hành vi khách hàng: Học tăng cường có thể giúp phân tích hành vi khách hàng và đưa ra các khuyến nghị về cách thức cải thiện trải nghiệm người dùng. Ví dụ, nếu khách hàng mở email nhưng không thực hiện hành động nào, hệ thống có thể học và điều chỉnh để cải thiện tỷ lệ mở và tương tác.

- Tối ưu hóa kênh phân phối: Việc áp dụng Reinforcement Learning trong marketing cũng giúp các doanh nghiệp tối ưu hóa các kênh phân phối, từ các cửa hàng trực tuyến đến các chiến dịch email, giúp tìm ra các kênh mang lại hiệu quả cao nhất cho doanh nghiệp.

7. Kết luận

Reinforcement Learning đã và đang mở ra những cơ hội mới trong việc phát triển các ứng dụng AI mạnh mẽ và tự động hóa, giúp các hệ thống AI ngày càng trở nên thông minh và linh hoạt hơn. Với những ứng dụng đa dạng từ robot, xe tự hành đến marketing và các ngành công nghiệp khác, Reinforcement Learning không chỉ thay đổi cách chúng ta giải quyết các vấn đề phức tạp mà còn là chìa khóa mở ra tương lai của trí tuệ nhân tạo tổng quát. Việc tiếp tục nghiên cứu và phát triển các kỹ thuật học tăng cường sẽ mang đến những đột phá mới, tạo ra những bước tiến mạnh mẽ hơn trong hành trình tiến gần đến một thế giới tự động hóa thông minh.