Data lake là một mô hình lưu trữ dữ liệu hiện đại và đang trở thành lựa chọn ưu tiên của nhiều doanh nghiệp nhờ khả năng lưu trữ linh hoạt, chi phí thấp và dễ mở rộng. Vậy data lake là gì, mang lại lợi ích gì và cần lưu ý gì khi triển khai hiệu quả? Trong bài viết dưới đây, Base.vn sẽ giúp bạn hiểu rõ toàn cảnh về data lake và cách tận dụng tối đa tiềm năng từ dữ liệu của mình.

1. Data lake là gì?

1.1 Định nghĩa

Data lake hay còn gọi là “hồ dữ liệu“, là một kho lưu trữ tập trung cho phép doanh nghiệp thu thập, lưu trữ, xử lý và bảo vệ khối lượng lớn dữ liệu từ nhiều nguồn khác nhau. Dữ liệu được lưu trữ ở dạng nguyên bản, bao gồm cả dữ liệu có cấu trúc, bán cấu trúc và phi cấu trúc, mà không bị giới hạn về kích thước hay định dạng.

Với khả năng lưu trữ linh hoạt và mở rộng, data lake giúp doanh nghiệp dễ dàng tích hợp và đồng bộ hóa dữ liệu gốc, từ đó tăng cường hiệu quả trong việc khai thác thông tin. Nhờ đó, dữ liệu từ nhiều nguồn với tốc độ khác nhau có thể được tập hợp và xử lý nhanh chóng trong cùng một hệ thống đáng tin cậy, hỗ trợ phân tích thời gian thực bằng nhiều công cụ và ngôn ngữ lập trình khác nhau.

1.2 Lịch sử và sự phát triển của data lake

Trong một thời gian dài, các tổ chức chủ yếu dựa vào cơ sở dữ liệu quan hệ (phát triển từ những năm 1970) và kho dữ liệu (ra đời vào thập niên 1980) để quản lý dữ liệu của mình. Những giải pháp này vẫn đóng vai trò quan trọng trong hệ sinh thái CNTT của nhiều doanh nghiệp, tuy nhiên chúng được thiết kế chủ yếu để xử lý các tập dữ liệu có cấu trúc.

Sự phát triển mạnh mẽ của Internet, đặc biệt là sự bùng nổ của mạng xã hội và các nền tảng truyền thông trực tuyến đã khiến nhiều doanh nghiệp phải đối mặt với khối lượng lớn dữ liệu phi cấu trúc, như văn bản hay hình ảnh. Với cấu trúc dữ liệu cứng nhắc cùng chi phí lưu trữ tương đối cao, các kho dữ liệu truyền thống và cơ sở dữ liệu quan hệ không còn phù hợp để xử lý dòng dữ liệu mới này.

Năm 2011, James Dixon, CTO của của Pentaho đã đưa ra khái niệm data lake. Ông xem đây là một lựa chọn thay thế cho mô hình kho dữ liệu truyền thống. Trong khi kho dữ liệu cung cấp thông tin đã qua xử lý phục vụ các mục đích kinh doanh cụ thể, thì data lake lại như một “kho chứa khổng lồ” tập hợp dữ liệu ở dạng nguyên bản. Người dùng có thể truy xuất dữ liệu họ cần từ hồ dữ liệu và sử dụng theo nhu cầu riêng.

Những data lake đầu tiên thường được xây dựng trên nền tảng Apache Hadoop – một framework mã nguồn mở hỗ trợ xử lý phân tán các tập dữ liệu lớn. Ban đầu, các hệ thống này được triển khai tại chỗ (on-premise), nhưng lại gặp nhiều hạn chế khi khối lượng dữ liệu tiếp tục tăng nhanh. Sau đó, điện toán đám mây đã mở ra giải pháp mới: di chuyển hồ dữ liệu lên các nền tảng lưu trữ đối tượng (object storage) trên cloud với khả năng mở rộng linh hoạt.

Hiện nay, data lake vẫn đang tiếp tục phát triển. Nhiều giải pháp hiện đại không chỉ cung cấp khả năng lưu trữ với chi phí thấp và khả năng mở rộng, mà còn tích hợp thêm các tính năng như bảo mật, quản trị dữ liệu, danh mục dữ liệu và quản lý metadata.

2. Phân biệt data lake và data warehouse

Data lake và data warehouse đều là những giải pháp phổ biến trong việc lưu trữ và xử lý dữ liệu quy mô lớn, tuy nhiên chúng phục vụ các mục đích khác nhau và không thể thay thế hoàn toàn cho nhau. Data Lake có thể hiểu là một “hồ dữ liệu” khổng lồ chứa thông tin ở dạng thô, chưa qua xử lý, với mục đích sử dụng còn mở và linh hoạt. Ngược lại, data warehouse là kho dữ liệu đã được tổ chức, chuẩn hóa và xử lý sẵn để phục vụ cho các mục tiêu phân tích cụ thể.

Chính vì vậy, mặc dù đôi khi hai khái niệm này bị nhầm lẫn, nhưng chúng thực chất là hai mô hình hoàn toàn khác biệt. Điểm chung cơ bản duy nhất giữa chúng là đều hướng đến việc lưu trữ dữ liệu ở cấp độ cao, phục vụ cho nhu cầu phân tích và ra quyết định.

Sự ra đời của mô hình lai data lakehouse là minh chứng rõ ràng cho nhu cầu kết hợp ưu điểm của cả hai – khả năng linh hoạt và lưu trữ dữ liệu nguyên bản của data lake, cùng với khả năng quản trị, phân tích hiệu quả của data warehouse.

Bạn có thể thấy rõ hơn sự khác biệt giữa data lake và data warehouse trong bảng dưới đây:

| Tiêu chí | Data lake | Data warehouse |

| Dữ liệu lưu trữ | Lưu trữ toàn bộ dữ liệu, không phân biệt loại hay mức độ xử lý. | Tập trung lưu trữ dữ liệu đã được chọn lọc và phục vụ mục tiêu phân tích. |

| Mức độ xử lý dữ liệu | Chủ yếu chứa dữ liệu thô, chưa qua xử lý. | Dữ liệu đã được xử lý, chuẩn hóa và sẵn sàng để phân tích. |

| Định dạng dữ liệu | Hỗ trợ mọi định dạng: có cấu trúc, bán cấu trúc và phi cấu trúc. | Chủ yếu lưu trữ dữ liệu có cấu trúc dạng bảng. |

| Mục đích sử dụng | Linh hoạt cho nhiều mục tiêu: phân tích, học máy, nghiên cứu… | Tối ưu cho báo cáo, truy vấn và phân tích kinh doanh. |

| Tính linh hoạt | Dễ dàng mở rộng và điều chỉnh theo nhu cầu. | Kém linh hoạt hơn do cấu trúc cố định và quy trình chặt chẽ. |

| Đối tượng sử dụng | Thường được sử dụng bởi các chuyên gia dữ liệu hoặc các nhà phân tích dữ liệu kỹ thuật cao. | Phù hợp với nhà phân tích kinh doanh và người dùng cuối. |

| Chi phí lưu trữ | Chi phí thấp nhờ sử dụng các hệ thống lưu trữ linh hoạt. | Chi phí cao hơn do yêu cầu hiệu suất và tốc độ truy xuất nhanh. |

| Bảo mật và kiểm soát | Mức độ kiểm soát bảo mật thường thấp hơn. | Hệ thống kiểm soát dữ liệu nghiêm ngặt và bảo mật tốt hơn. |

| Vai trò với kho dữ liệu doanh nghiệp (Enterprise Data Warehouse – EDW) | Có thể đóng vai trò là nguồn cấp dữ liệu cho EDW. | Hỗ trợ hoạt động phân tích nhưng không thay thế EDW. |

| Lược đồ dữ liệu | Lược đồ được áp dụng khi truy xuất dữ liệu (schema-on-read). | Lược đồ được xác định trước khi lưu trữ (schema-on-write). |

| Khả năng xử lý dữ liệu mới | Cho phép đưa dữ liệu mới vào hệ thống nhanh chóng. | Quá trình tích hợp dữ liệu mới phức tạp và mất thời gian hơn. |

| Mức độ chi tiết dữ liệu | Dữ liệu được lưu trữ dưới dạng gốc hoặc chi tiết thấp. | Dữ liệu thường đã được tổng hợp, làm sạch và chi tiết hóa. |

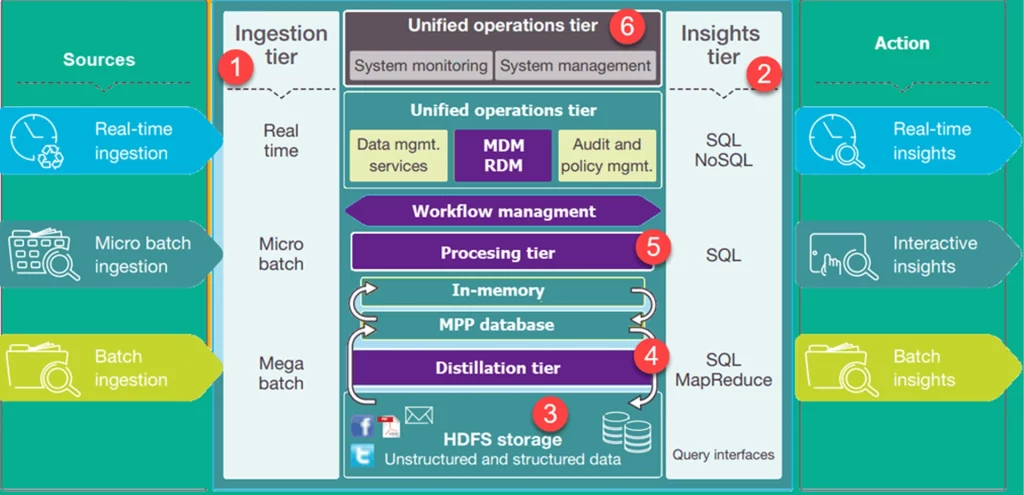

3. Kiến trúc của data lake

Hình minh họa trên mô phỏng cấu trúc tổng thể của một kiến trúc data lake trong doanh nghiệp. Ở các tầng thấp, dữ liệu chủ yếu ở trạng thái tĩnh, trong khi càng lên cao thì dữ liệu càng mang tính giao dịch và được xử lý theo thời gian thực. Dòng chảy dữ liệu xuyên suốt hệ thống diễn ra với độ trễ thấp hoặc gần như không có. Dưới đây là các tầng chính trong kiến trúc này:

- Tầng tiếp nhận dữ liệu (Ingestion Tier): Phía bên trái thể hiện các nguồn dữ liệu đầu vào. Tùy vào nhu cầu, dữ liệu có thể được đưa vào hệ thống theo lô hoặc theo thời gian thực.

- Tầng khai thác thông tin (Insights Tier): Phía bên phải đại diện cho các hoạt động phân tích, nơi dữ liệu được truy vấn và trích xuất thông tin. Người dùng có thể sử dụng các công cụ như SQL, NoSQL hoặc Excel để phục vụ quá trình phân tích.

- HDFS (Hadoop Distributed File System): Đây là nền tảng lưu trữ dữ liệu chính, có thể xử lý hiệu quả cả dữ liệu có cấu trúc và phi cấu trúc với chi phí tiết kiệm. Nơi này được xem là “điểm đến đầu tiên” của dữ liệu khi được đưa vào hệ thống.

- Tầng chưng cất dữ liệu (Distillation Tier): Tầng này lấy dữ liệu từ kho lưu trữ và chuyển đổi nó thành định dạng có cấu trúc hơn, giúp cho việc phân tích trở nên dễ dàng và hiệu quả hơn.

- Tầng xử lý (Processing Tier): Đây là nơi triển khai các thuật toán phân tích và thực thi các truy vấn, từ tương tác theo thời gian thực cho đến xử lý theo lô nhằm tạo ra dữ liệu có cấu trúc phục vụ nhu cầu phân tích sâu hơn.

- Tầng vận hành hợp nhất (Unified Operations Tier): Tầng này đóng vai trò điều phối và giám sát toàn bộ hoạt động của hệ thống. Bao gồm các chức năng như kiểm tra, quản trị dữ liệu, quản lý luồng công việc và các hoạt động vận hành khác.

Đọc thêm: Data Mining là gì? 4 bước quan trọng trong khai phá dữ liệu

4. Lợi ích của Data Lake

Data lake ngày càng được ưa chuộng trong các hệ thống quản lý dữ liệu hiện đại nhờ khả năng linh hoạt, tiết kiệm chi phí và mở rộng hiệu quả. Dưới đây là những lợi ích nổi bật mà hồ dữ liệu mang lại cho doanh nghiệp:

4.1 Linh hoạt trong lưu trữ và xử lý dữ liệu

Data Lake có thể tiếp nhận và lưu trữ nhiều loại dữ liệu khác nhau, từ dữ liệu có cấu trúc (structured) như bảng tính và cơ sở dữ liệu, đến dữ liệu bán cấu trúc (semi-structured) như JSON, XML, và cả dữ liệu phi cấu trúc (unstructured) như hình ảnh, video, văn bản tự do. Nhờ đó, doanh nghiệp không cần duy trì nhiều hệ thống lưu trữ riêng biệt, giúp đơn giản hóa kiến trúc dữ liệu tổng thể.

4.2 Tối ưu chi phí

Dữ liệu được lưu trữ trong data lake không cần trải qua quy trình làm sạch và chuyển đổi phức tạp ngay từ đầu. Đồng thời, việc sử dụng các dịch vụ lưu trữ đám mây giúp doanh nghiệp tiết kiệm đáng kể so với các giải pháp lưu trữ truyền thống tại chỗ. Điều này cho phép doanh nghiệp phân bổ ngân sách hiệu quả hơn cho các hoạt động quản lý và phân tích dữ liệu.

4.3 Dễ dàng mở rộng

Nhờ tách biệt giữa khả năng lưu trữ và xử lý, data lake có thể dễ dàng mở rộng quy mô khi khối lượng dữ liệu tăng lên. Các nền tảng đám mây hiện nay cho phép doanh nghiệp nâng cấp hoặc điều chỉnh tài nguyên một cách linh hoạt, đáp ứng nhanh chóng nhu cầu thay đổi của hệ thống dữ liệu.

4.4 Giảm thiểu tình trạng phân mảnh dữ liệu (data silo)

Theo thống kê từ IBM, có tới 61% doanh nghiệp cho rằng các “kho dữ liệu cục bộ” là một trong những thách thức lớn nhất trong việc khai thác dữ liệu. Data lake giúp khắc phục tình trạng này bằng cách tạo ra một kho dữ liệu trung tâm, nơi mọi loại dữ liệu đều có thể được tập trung lưu trữ và truy cập dễ dàng. Việc này không chỉ cải thiện khả năng chia sẻ dữ liệu giữa các bộ phận, mà còn nâng cao hiệu quả phân tích toàn doanh nghiệp.

5. Triển khai data lake ở đâu: Trên nền tảng đám mây hay tại chỗ?

Khi triển khai data lake, một trong những quyết định quan trọng mà doanh nghiệp cần cân nhắc là lựa chọn hạ tầng phù hợp: triển khai tại chỗ (on-premise) hay trên nền tảng đám mây (cloud).

Trước đây, phần lớn các data lake được xây dựng trong các trung tâm dữ liệu nội bộ của doanh nghiệp. Tuy nhiên, cùng với sự phát triển nhanh chóng của công nghệ điện toán đám mây và các nền tảng dữ liệu lớn, xu hướng triển khai data lake trên cloud ngày càng phổ biến.

Các dịch vụ như Amazon EMR, Azure HDInsight và Google Dataproc đã giúp đơn giản hóa quá trình xử lý và phân tích dữ liệu lớn trên môi trường đám mây. Đồng thời, việc sử dụng các dịch vụ lưu trữ đối tượng như Amazon S3, Azure Blob Storage hay Google Cloud Storage mang lại khả năng mở rộng linh hoạt, chi phí lưu trữ thấp hơn và khả năng tích hợp tốt với các công cụ phân tích hiện đại.

Không dừng lại ở đó, các nhà cung cấp đám mây còn liên tục cải tiến, bổ sung thêm nhiều dịch vụ hỗ trợ tích hợp dữ liệu, quản trị dữ liệu và xây dựng hệ thống tự động giúp các doanh nghiệp dễ dàng triển khai và vận hành data lake một cách hiệu quả.

Mặc dù vậy, triển khai tại chỗ vẫn là lựa chọn phù hợp trong một số tình huống cụ thể, đặc biệt với những tổ chức có yêu cầu cao về kiểm soát dữ liệu, bảo mật nội bộ hoặc đã đầu tư đáng kể vào hạ tầng hiện có.

Ví dụ: Cloudera, một trong những công ty tiên phong trong lĩnh vực xử lý dữ liệu lớn cho biết tính đến năm 2019, khoảng 90% doanh thu của họ đến từ khách hàng sử dụng hạ tầng on-premise. Hiện nay, Cloudera cũng đã phát triển nền tảng hỗ trợ cả cloud-native và hệ thống lưu trữ tại chỗ, cho phép doanh nghiệp lựa chọn linh hoạt tùy theo nhu cầu.

Tóm lại, lựa chọn triển khai data lake trên nền tảng đám mây hay tại chỗ phụ thuộc vào nhiều yếu tố: ngân sách, yêu cầu bảo mật, hạ tầng sẵn có, và chiến lược phát triển dài hạn của doanh nghiệp. Cả hai mô hình đều có ưu điểm riêng, quan trọng là doanh nghiệp cầnxác định đâu là giải pháp phù hợp nhất với thực tiễn hoạt động và mục tiêu dữ liệu của bạn.

6. Thách thức khi triển khai data trong doanh nghiệp

Mặc dù data lake mang lại nhiều lợi ích về tính linh hoạt, khả năng lưu trữ dữ liệu đa dạng và chi phí thấp, nhưng việc triển khai và vận hành một hệ thống data lake hiệu quả không phải lúc nào cũng đơn giản. Dưới đây là một số thách thức phổ biến mà các tổ chức thường gặp:

6.1 Quản trị và chất lượng dữ liệu

Do đặc điểm không yêu cầu lược đồ (schema) nghiêm ngặt và chấp nhận nhiều loại dữ liệu từ các nguồn khác nhau, data lake rất dễ rơi vào tình trạng “hồ dữ liệu bị ô nhiễm” (data swamp) nếu không được quản lý tốt. Khi đó, dữ liệu trở nên lộn xộn, thiếu nhất quán và khó sử dụng, khiến người dùng khó khai thác được thông tin giá trị phục vụ cho phân tích hay ra quyết định.

Để khắc phục điều này, tổ chức cần đầu tư vào các công cụ phân loại và gắn thẻ dữ liệu như hệ thống quản lý siêu dữ liệu (metadata management), danh mục dữ liệu (data catalog), giúp việc tìm kiếm và khai thác dữ liệu trở nên dễ dàng hơn.

Ngoài ra, việc áp dụng các giải pháp quản trị và bảo mật dữ liệu như: kiểm soát quyền truy cập, ngăn chặn rò rỉ dữ liệu, phát hiện và phản ứng với hành vi bất thường… cũng là điều cần thiết để đảm bảo dữ liệu được sử dụng đúng mục đích và không bị truy cập trái phép.

6.2 Hiệu suất xử lý và truy vấn

Không giống như các hệ thống data warehouse hay data lakehouse vốn thường đi kèm các công cụ xử lý và truy vấn tích hợp, data lake thuần túy không có sẵn những tính năng này. Khi khối lượng dữ liệu ngày càng lớn, hiệu suất truy vấn và phân tích có thể giảm đáng kể, đặc biệt nếu dữ liệu không được lưu trữ hoặc tối ưu hóa đúng cách.

Để đảm bảo hiệu năng cao và ổn định, tổ chức cần lựa chọn đúng công cụ và cấu hình phù hợp: ví dụ như định dạng lưu trữ tối ưu (Parquet, ORC…), sử dụng các công cụ truy vấn hiệu quả (như Presto, Athena, Dremio…) và xây dựng kiến trúc phù hợp với quy mô dữ liệu hiện tại và tương lai.

7. Ứng dụng của data lake trong doanh nghiệp

Data lake không chỉ đơn thuần là nơi lưu trữ dữ liệu, mà còn đóng vai trò như một nền tảng quan trọng hỗ trợ các hoạt động phân tích, dự báo và ra quyết định trong doanh nghiệp.

7.1 Kho lưu trữ tổng hợp cho mọi loại dữ liệu

Nhờ khả năng lưu trữ dữ liệu ở nhiều định dạng khác nhau, data lake thường được sử dụng như một “kho lưu trữ vạn năng” cho tất cả dữ liệu đầu vào. Thay vì xây dựng nhiều luồng xử lý riêng biệt cho từng loại dữ liệu, doanh nghiệp có thể tập trung toàn bộ dữ liệu vào một hệ thống duy nhất. Người dùng có thể truy xuất trực tiếp từ data lake hoặc chuyển tiếp sang các nền tảng dữ liệu khác khi cần.

Thậm chí, data lake còn phù hợp để lưu trữ những dữ liệu “dự phòng” – dữ liệu chưa có mục đích sử dụng rõ ràng ở thời điểm hiện tại nhờ chi phí lưu trữ thấp và khả năng mở rộng linh hoạt.

7.2 Lưu trữ dữ liệu không hoạt động, sao lưu và khôi phục

Một ứng dụng phổ biến khác của data lake là làm kho lưu trữ cho dữ liệu không thường xuyên truy cập (cold data) hoặc dữ liệu cần lưu trữ lâu dài như sao lưu hệ thống, lưu trữ phục hồi sau sự cố (disaster recovery), hoặc dữ liệu lịch sử phục vụ cho kiểm toán và tuân thủ pháp lý. Với chi phí hợp lý và khả năng lưu trữ khối lượng lớn, data lake là lựa chọn phù hợp cho các nhu cầu lưu trữ này mà không gây áp lực lên ngân sách.

7.3 Phân tích dữ liệu lớn, AI và Machine Learning

Các mô hình trí tuệ nhân tạo (AI), học máy (Machine Learning) và các ứng dụng phân tích dữ liệu quy mô lớn đều yêu cầu lượng dữ liệu đầu vào rất lớn, đặc biệt là dữ liệu phi cấu trúc (như hình ảnh, âm thanh, văn bản…). Data lake cung cấp nền tảng lý tưởng để lưu trữ và xử lý những loại dữ liệu này với chi phí tiết kiệm và hiệu quả cao, tạo điều kiện để doanh nghiệp phát triển các mô hình dự báo, tự động hóa hoặc ứng dụng AI sáng tạo (như Generative AI).

7.4 Hỗ trợ tích hợp dữ liệu và chia sẻ dữ liệu

Một trong những thách thức lớn trong quản lý dữ liệu chính là việc dữ liệu bị phân tán ở nhiều bộ phận, hệ thống khác nhau, gây khó khăn trong việc khai thác và ra quyết định. Data lake giúp giải quyết vấn đề này bằng cách tạo ra một kho dữ liệu tập trung, nơi tất cả dữ liệu từ nhiều nguồn có thể được hợp nhất, đồng bộ và dễ dàng truy cập. Việc này không chỉ nâng cao hiệu quả tích hợp dữ liệu mà còn thúc đẩy chia sẻ dữ liệu nội bộ, tạo điều kiện cho các bộ phận phối hợp và tận dụng dữ liệu tốt hơn.

Đọc thêm: Công nghệ AI là gì? Ứng dụng trí tuệ nhân tạo AI trong doanh nghiệp

8. Làm gì để quản lý data lake hiệu quả?

Một data lake được triển khai không đúng cách rất dễ rơi vào tình trạng “Data Swamp”, tức là nơi dữ liệu trở nên hỗn loạn, không thể kiểm soát, gây khó khăn trong truy xuất và phân tích. Để phát huy tối đa giá trị của data lake, doanh nghiệp cần xây dựng chiến lược quản lý hiệu quả ngay từ đầu.

8.1 Xây dựng chiến lược quản trị dữ liệu rõ ràng

Một chiến lược quản trị dữ liệu toàn diện sẽ giúp xác định:

- Ai có quyền truy cập dữ liệu nào

- Dữ liệu được thu thập và lưu trữ như thế nào

- Quy trình kiểm tra, xác thực và cập nhật dữ liệu

Doanh nghiệp nên áp dụng các chính sách như kiểm soát truy cập (Access Control), phân quyền người dùng và tuân thủ các tiêu chuẩn bảo mật phù hợp với ngành nghề (ví dụ: ISO, GDPR…).

8.2 Gắn thẻ và phân loại dữ liệu bằng metadata

Metadata (siêu dữ liệu) là “nhãn dán” mô tả thông tin về dữ liệu (nguồn, định dạng, thời gian tạo, người tạo…). Việc gắn metadata giúp người dùng:

- Dễ dàng tìm kiếm và định vị dữ liệu

- Hiểu rõ bối cảnh sử dụng của từng tập dữ liệu

- Hạn chế dữ liệu trùng lặp, không cần thiết

Các công cụ hỗ trợ phổ biến như: data catalog, metadata management platform (Alation, Collibra, Apache Atlas…) có thể được tích hợp vào hệ thống để tự động hóa quá trình này.

8.3 Theo dõi chất lượng dữ liệu thường xuyên

Chất lượng dữ liệu ảnh hưởng trực tiếp đến hiệu quả phân tích và ra quyết định. Doanh nghiệp nên sử dụng các công cụ kiểm soát chất lượng dữ liệu để phát hiện và xử lý lỗi sớm, đồng thời thiết lập quy trình xác nhận trước khi đưa dữ liệu vào khai thác. Một số tiêu chí cần theo dõi:

- Tính đầy đủ

- Độ chính xác

- Tính nhất quán

- Tính kịp thời

8.4 Tối ưu hóa hiệu suất truy vấn và phân tích

Vì data lake lưu trữ nhiều định dạng dữ liệu phi cấu trúc, nên để đảm bảo hiệu suất xử lý, doanh nghiệp cần:

- Sử dụng các định dạng lưu trữ tối ưu (như Parquet, ORC…)

- Tích hợp các công cụ truy vấn mạnh mẽ như Presto, Apache Drill, Trino…

- Phân vùng dữ liệu (partitioning) và tạo chỉ mục hợp lý

Giải pháp này giúp tăng tốc độ truy vấn và giảm chi phí tính toán khi xử lý khối lượng dữ liệu lớn.

8.5 Tự động hóa và chuẩn hóa quy trình xử lý dữ liệu

Việc tự động hóa các bước từ ingest (đưa dữ liệu vào), làm sạch, đến chuẩn hóa dữ liệu giúp:

- Giảm thiểu sai sót do thao tác thủ công

- Đảm bảo tính nhất quán trong quản lý dữ liệu

- Tăng hiệu suất vận hành tổng thể của hệ thống

Các nền tảng như Apache NiFi, AWS Glue hoặc Azure Data Factory có thể hỗ trợ xây dựng pipeline xử lý dữ liệu tự động và có thể mở rộng.

8.6 Giám sát và đánh giá định kỳ

Cuối cùng, để đảm bảo hệ thống data lake hoạt động đúng hướng, cần có cơ chế:

- Theo dõi hiệu suất lưu trữ, xử lý, truy cập

- Báo cáo lỗi và các hành vi bất thường

- Đánh giá định kỳ về mức độ sử dụng và hiệu quả dữ liệu

Việc này giúp doanh nghiệp kịp thời điều chỉnh cấu trúc hoặc chính sách khi khối lượng và nhu cầu dữ liệu thay đổi.

9. Kết luận

Data lake không chỉ là một kho lưu trữ dữ liệu đơn thuần, mà còn là nền tảng chiến lược giúp doanh nghiệp linh hoạt thích ứng với sự phát triển nhanh chóng của công nghệ và nhu cầu phân tích dữ liệu chuyên sâu. Khi được triển khai và quản lý đúng cách, data lake sẽ trở thành “trung tâm thần kinh” hỗ trợ ra quyết định, tối ưu vận hành và dẫn dắt đổi mới. Tuy nhiên, để triển khai data lake hiệu quả, doanh nghiệp cần có chiến lược rõ ràng về quản trị, bảo mật và tích hợp dữ liệu.